自主 Agent 核心概念

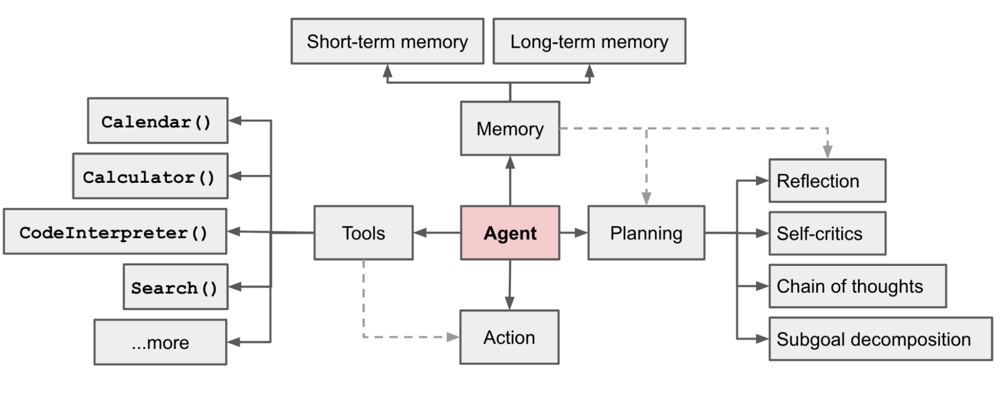

LLM 作为自主 Agent:大型语言模型(LLM)可以充当自主智能体(Agent)的“大脑”,通过生成自然语言“思考”和决策来控制行动。在这样的系统中,LLM 接受高层目标或任务指令,内部产生一系列推理步骤,然后将这些推理用于选择下一步动作(例如调用工具、查询数据或输出答案)。由于单纯的语言模型本身只能输出文本,不会直接执行操作,Agent 需要将模型输出与环境交互结合,使模型的决策能转化为实际行动。为此,LLM 自主Agent一般配备额外的组件来辅助决策,包括规划(Planning)、记忆(Memory)和工具使用(Tool Use)等模块。(如图1所示)。

*图1:LLM 驱动自主 Agent 系统概览。LLM 作为核心Agent,配合规划模块(子目标分解、自我反思等)、记忆模块(短期/长期记忆)以及外部工具接口,实现复杂任务的自主决策和执行

长程记忆与上下文管理:LLM 的上下文窗口有限,难以直接记住长久的信息,因此自主Agent通常需要模拟短期记忆和长期记忆机制。短期记忆指模型在当前对话或当前任务步骤中保留的上下文(例如最近的对话历史或近期结果),相当于模型的工作内存;长期记忆则通过外部存储(如向量数据库)来保存更久远或更大量的信息,并在需要时检索相关内容供模型参考。例如,一个Agent可以将之前的对话摘要、先前任务的结果向量化存储,当面对相关问题时再检索出来放入提示中。通过这种检索增强(RAG)技术,Agent 得以突破原始上下文长度限制。此外,上下文管理还包括根据当前任务动态筛选或总结信息,确保模型每一步看到的提示既包含关键历史又不过载。有效的上下文管理使Agent在长任务中保持连贯,不会因为遗忘先前内容而偏离目标。

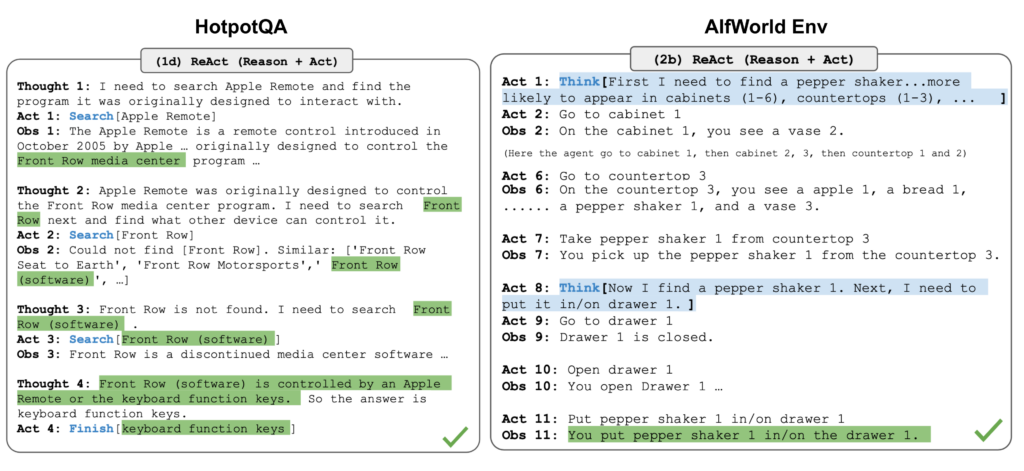

规划与执行循环:自主Agent需要将复杂任务分解成可管理的子任务,并通过循环的方式逐步完成。常用方法是链式思考 (Chain-of-Thought, CoT) 提示,让模型“逐步思考”当前应该做什么。模型会在内部推理下一步行动计划,然后执行该行动,再观察结果,将结果纳入下一次决策,这形成了思考-行动-观察的循环(Think-Act-Observe Loop)。例如,模型可能先推理“我需要查询资料”,然后输出一个调用搜索工具的指令,接收搜索结果后再据此推理下一个步骤,反复迭代直至完成目标。这个循环类似人类解决问题的过程:不断计划、执行、根据反馈调整计划。为提高规划效果,Agent 可以采用子目标分解(将大任务拆解为多步)以及自我反思(在每轮行动后审视是否偏差或有更优解)等策略。例如,Agent可能在执行若干步后暂停,总结哪里出错,并修改后续计划,从而逐步逼近正确结果。(如图2所示)。

*图2:LLM 决策任务的推理轨迹

主要架构设计

ReAct 架构:ReAct(Reasoning and Acting)是一种将推理和行动相结合的提示架构,由 Yao 等人提出。在 ReAct 中,LLM 的输出被设计为交替包含“思考 (Thought)”和“行动 (Action)”以及对行动的反馈“观察 (Observation)”。具体而言,模型先输出思考内容,随后输出要执行的动作指令,然后接收环境返回的观察结果,再将其与先前思考共同作为下轮输入,循环往复。这种架构将自然语言推理与离散工具操作融合为一体,使模型既能进行复杂逻辑推演,又能通过调用外部工具与环境交互。实验证明,在问答、推理等任务上,采用 ReAct 格式(显式地思考并行动)比仅让模型直接输出答案的基线效果更好。ReAct 为后续众多Agent框架奠定了基础——例如 LangChain 的Agent就是通过类似ReAct的模板,让模型产生行动指令再执行工具,再把结果反馈给模型,逐步完成任务。

决策流程与优化:自主Agent的决策流程通常包含感知-思考-行动的闭环:Agent从环境获取信息或用户输入(感知),结合内部记忆和目标进行推理决策(思考),执行选定的操作(行动),接着获取操作结果(新的感知),并用于下一轮循环 。为了使这一过程更高效、可靠,研究者提出了多种优化策略:

- 自我反思 (Self-Reflection):Agent定期评估自己的行动效果,进行自我批评和调整。例如 Reflexion 框架引入了动态记忆和反思机制:每当Agent发现陷入重复无效动作或产生错误结果时,就记录一条反思信息到记忆中,提示模型在后续规划时避免相同错误。这种通过过去失败经验来调整未来决策的做法,让Agent逐步提高成功率。

- 多路径推理:相比单线性思考,一些方法让Agent尝试多种思路,然后择优。典型如思维树 (Tree-of-Thoughts),模型在每步产生不止一个候选想法,形成树状搜索,通过评估或投票选择最有前途的分支继续。这种启发式搜索提高了找到正确解法的概率。另一思路是将规划外包给经典算法,例如 LLM+P 方法让LLM生成规划问题描述,调用传统规划器求解,再由LLM把结果转为自然语言。

- 强化学习与反馈优化:通过人为或自动的反馈来提升Agent决策质量。例如Hindsight Feedback方法,将模型过去的输出和对应的人类反馈一起输入,让模型学习哪些行为得到高分反馈,从而在生成新方案时趋向成功模式。

- 减少错误与幻觉:模型有时会输出格式错误或不符合预期的内容,从而导致工具调用失败或逻辑混乱。为此,一些优化包括严格的输出格式约束(例如 OpenAI 函数调用要求模型必须产出JSON),以及对模型输出进行解析校验。此外,设置停机条件也很重要,例如检测到Agent重复同一动作多次却没有新进展时应终止循环。这些措施能避免Agent陷入死循环或产生危险操作。

综上,当前自主Agent架构通过融合明确的思考流程 (ReAct)、强大的LLM推理和外部工具交互,再结合各种优化策略,已经能够在一定程度上自主执行复杂任务。同时也不断改进规划深度、记忆广度和决策可靠性,以进一步接近人类的自主 problem-solving 能力。

MCP 机制原理

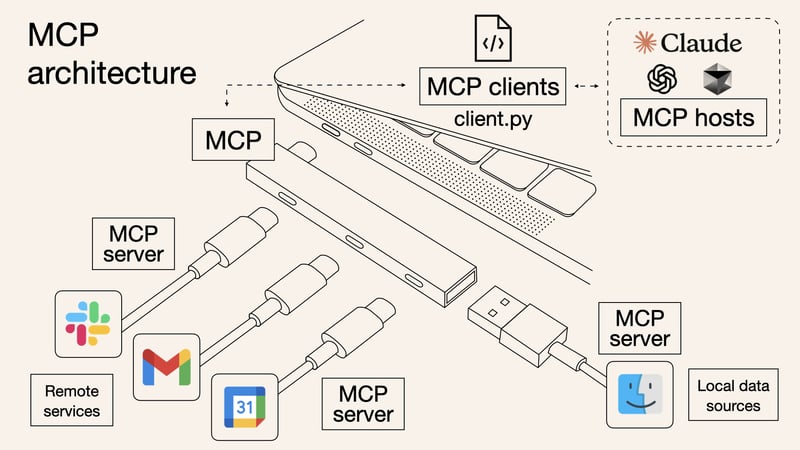

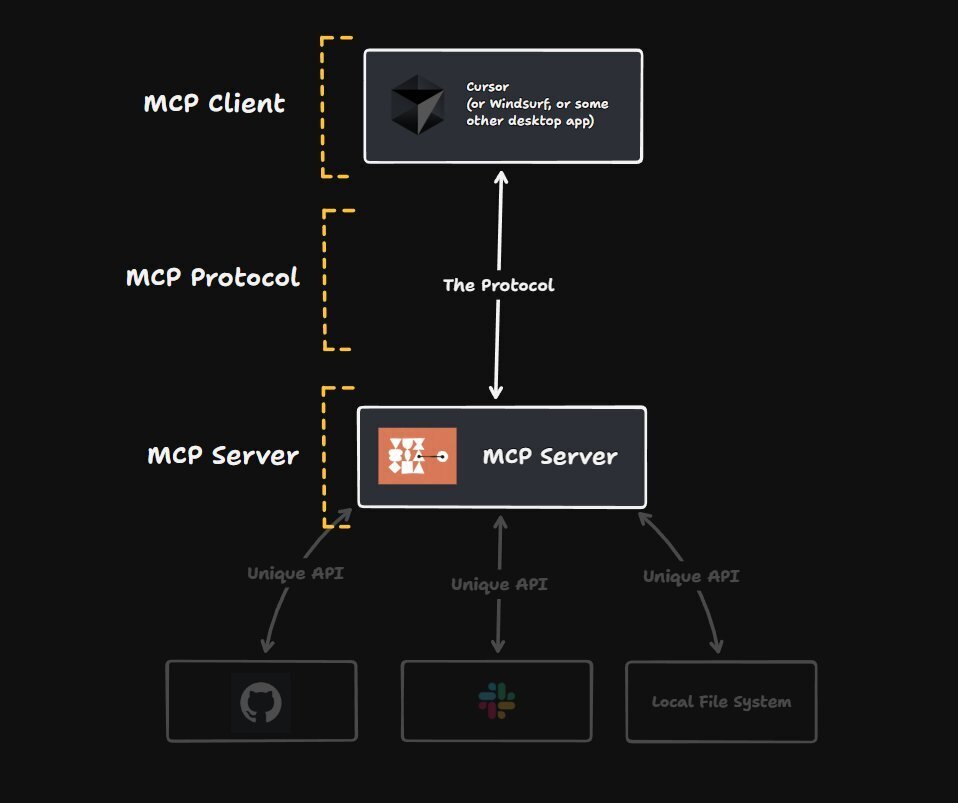

MCP 概述:模型上下文协议 (Model Context Protocol, MCP) 是 Anthropic 公司于 2024 年底提出的开放标准,旨在规范 LLM 与外部工具/数据源的交互接口。自主 Agent 要与外部世界交互,就需要一种标准、安全的渠道将 LLM 和外部工具、数据连接起来。模型上下文协议正是为此设计的一套新兴开放标准。(如图3,图4所示)。

*图3:简单来说,MCP 为 AI 模型连接外部世界提供了类似“USB-C”的通用接口。

*图4:MCP 模型-上下文协议架构示意。客户端(如 IDE 编辑器 Cursor )通过标准协议连接一个或多个 MCP 服务器,使 LLM 能安全地访问外部工具和数据源(例如代码仓库、Slack 聊天记录或本地文件系统)。MCP 将各类资源抽象为统一接口,就像 AI 领域的“USB-C”端口,将模型与外部世界相连。

统一协议与双向交互: MCP 采用客户端-服务器架构,规定了客户端(承载或代理 LLM 的应用,如 Claude Desktop、IDE 插件等)如何与服务器(封装某类外部数据或服务的接口模块)进行通信。通过遵循统一的协议标准,任何兼容的客户端都能连接任意第三方开发的 MCP 服务器,从而“一次接入,随处可用”。这种标准化类似于语言服务器协议(LSP)之于编辑器生态,为 AI 工具生态提供了通用“端口”。值得一提的是,MCP 强调双向通信:LLM 可以向服务器发送指令请求,服务器也能实时将消息或数据推送给模型。这种持续会话连接(可通过标准输入输出流、Server-Sent Events 等实现)类似于 WebSocket 带来的长连接效果,使模型与工具之间能进行状态保持的对话式交互,而非一次性函数调用。

工具调用机制:MCP 为 LLM 调用外部工具提供了标准化流程。在MCP框架下,MCP客户端充当 LLM 与 MCP服务器之间的中介桥梁。 典型交互过程如下:

- 获取工具列表:启动时,MCP Client 会从连接的 MCP Server 获取可用工具及资源的描述列表。这些工具描述包括功能名称、参数说明等,供后续模型决策使用。

- 发送复合提示:当用户提出请求后,MCP Client 将用户的询问与可用工具描述一起打包,通过模型的函数调用接口发送给 LLM。也就是说,LLM 知道当前有哪些工具可用,以及它们能做什么。

- 模型决策调用:LLM 收到扩充过的提示后,决定是否以及如何使用工具。如果需要,它会在回答中以特殊格式(如函数名和参数)提出工具调用意图。这一过程利用了类似 OpenAI Function Calling 的机制:模型输出的函数名和参数被结构化解析。

- 执行工具并返回结果:MCP Client 解析模型输出的工具调用指令,立即通过 MCP Server 调用对应工具或查询资源。MCP Server 接收到调用请求后,与本地或远程资源交互(例如读取文件、查询数据库或请求API),然后将结果返回给 MCP Client。

- 模型生成最终响应:MCP Client 将工具返回的数据送回 LLM,作为新的上下文让模型继续生成回答。LLM 综合工具结果和原始询问,生成最终的自然语言响应输出给用户。整个过程中,用户看到的只是问题和答案,工具调用在幕后由 MCP 协议透明地完成。

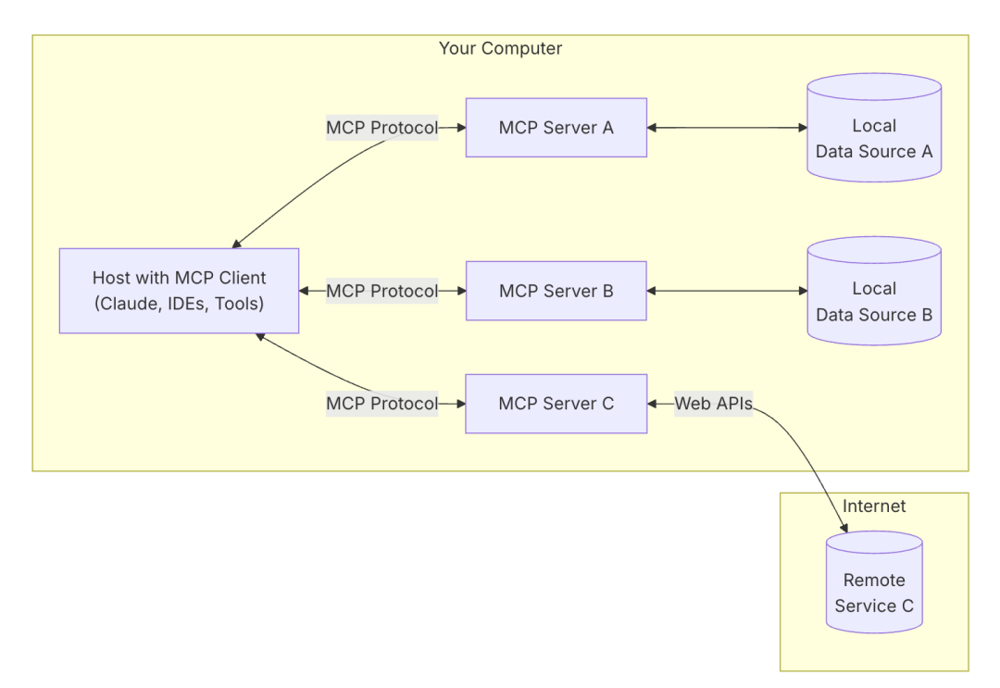

通过上述机制,LLM 能够动态调动外部能力完成原本无法独立完成的任务,例如检索实时信息、执行计算、访问私有数据库等。和直接内置的函数调用相比,MCP 将工具接入解耦为标准协议,因此扩展性更强:不仅LLM本身,其他应用也可遵循 MCP 接入同样的工具生态。换言之,MCP 不局限于“增强某个模型”,而是致力于构建模型与外界交互的统一基础设施。此外,MCP 支持本地通信或网络通信两种模式,均采用 JSON-RPC 2.0 格式传输消息,从而保证消息解析的一致性和可靠性。在本地模式下,MCP Client 与 Server 可通过标准输入输出管道通信(适用于模型在本地主机运行的场景);在远程模式下,则通过HTTP的服务端推送事件(SSE)(最新规范版本使用更灵活的Streamable HTTP 传输取代了之前的 HTTP+SSE 传输)进行实时数据传输,方便跨网络调用种设计使得无论AI部署在本地还是云端,都可以方便地利用 MCP 接入所需工具。(如图5所示)。

*图5:MCP 模型上下文协议架构示意。在本地主机上,带有 MCP Client 的应用通过 MCP 协议连接多个 MCP Server,以访问不同的本地数据源或远程API服务。这种标准化的客户端-服务器架构,使 LLM 能安全地获取所需上下文数据和执行外部操作。

对比 OpenAI 函数调用与 Claude 工具使用: OpenAI 于 2023 年推出的函数调用为模型调用工具提供了雏形——开发者在接口中定义可用函数,模型输出 JSON 格式的参数来调用这些函数,由外部程序执行并将结果反馈给模型。Claude 早期也支持类似地调用工具。但这些方案大多是厂商自定义的单向接口,耦合较深。而 MCP 将这一过程标准化并扩展:模型不再直接调用具体函数,而是通过 MCP 协议与服务器协商调用。服务器可以封装任意类型的资源访问或操作(API、数据库查询、文件读取等),并确保对模型提供受控的上下文信息。这样的设计在安全隔离上更进一步——工具的执行在 MCP 服务器端完成,LLM 只能通过协议获得结果或有限的资源视图。这相当于在模型和真实环境之间加了一层“沙箱”。例如,OpenAI 的 Code Interpreter 插件也是在云端沙盒中执行Python代码并将结果返回,大大降低了直接运行用户代码的风险。类似地,MCP 服务器可以在受限权限的环境中执行指令、访问数据,避免暴露底层系统给模型,从而提供安全隔离与权限管控。

生态系统与应用集成: 作为开放标准,MCP 正受到越来越多平台的支持。例如 Anthropic 已在 Claude 的桌面应用中内置了本地 MCP 客户端支持,并提供了一系列开源 MCP 服务器实现,覆盖 Google Drive、Slack、GitHub、数据库等常用数据源。一些开发者工具公司(如 Zed 编辑器、Replit 在线IDE、Codeium、Sourcegraph 等)也正与 MCP 集成,把各自平台功能通过 MCP 暴露出来,让 AI Agent 能更方便地获取代码上下文,提高生成代码的准确性。可以预见,随着 MCP 生态完善,未来不同模型、应用与工具之间的集成将更加即插即用:正如标准化的浏览器插件、IDE 插件一样,一个遵循 MCP 标准的工具模块可以服务于任意支持 MCP 的 AI Agent 客户端。这种标准化趋势有望促成一个繁荣的 AI 插件生态,加速 Agent 在各领域的落地。

LLM Agent 项目案例

Manus – 多角色协作式 Agent

Manus(由创业公司 Monica.im 开发)宣称是全球首个全自主 AI Agent 系统,目前处于内测阶段。当前推测它采用了一个类似团队协作的多智能体架构:中央的主代理就像项目经理,能够将复杂目标任务拆解后,交由不同专职子代理去完成,并最终整合各子任务结果。每个子代理擅长一类职能,例如网络检索、代码编写、数据分析等。这样的模块化分工使 Manus 尤其适合较大型的开发任务——它可以同时扮演多个开发角色并行工作:例如在一个软件项目中,一个子代理编写前端代码的框架,另一个撰写后端逻辑,还有一个代理负责测试或文档。主代理则持续进行规划和协调,在后台异步地驱动整个开发流程。这种架构充分发挥了 Agent 团队协作的威力,使 Manus 能够在无需人工干预的情况下自行完成端到端的复杂任务。正如有报道所述,Manus 实际上集成并微调了 Anthropic 的 Claude 和阿里巴巴通义 Qwen 等多个大型模型,通过分工配合实现更高可靠性。

Roo Code / Roo Cline – 多模型协作的代码工具

Roo Code(前身名为 Roo Cline)是一个面向代码编写的 Agent 驱动平台,其形式是集成到开发者代码编辑器中的AI助手。可以把它想象成你的 IDE 中驻扎着一支由 AI 组成的开发团队:Roo Code 支持自然语言对话,理解开发者的意图;它能够直接读取和修改项目文件,在本地执行终端命令(如运行构建、测试),甚至在浏览器中执行操作(例如访问某API或文档网页)与一般的代码补全工具不同,Roo Code 设计为可插入多种模型,并允许用户定制 Agent 的“人格”和工作模式。例如,你可以让它以严格的架构师角色来审查代码结构,或以 QA 工程师角色专注于测试。通过这种多角色配置,Roo Code 实现了 AI Agent 在开发流程中的协同创作。在功能上,它几乎覆盖了开发工作的各个方面:从根据需求自动生成新代码,到重构和调试现有代码,再到撰写或更新文档,以及根据代码库回答问题等。比较推荐查看:https://docs.roocode.com/community 了解更高层次的指令驱动整个团队式的编码过程。

关键演进趋势

- 多智能体协同(团队模式):由单一 Agent 向多 Agent 团队演进,多个专职 Agent 分担不同任务角色,提高并行效率和专业性。例如 Manus 通过多个子代理分工协作完成复杂任务。未来的 AI 系统可能由一组 Agent 组成“虚拟团队”,如同不同部门的员工各司其职,这要求高效的Agent通信和调度机制来协调它们的行为。

- 多模型系统(规划者 vs 执行者):为了兼顾智能水平和执行效率,出现了将不同规模/专长的模型组合使用的架构。一种常见模式是**“大模型规划,小模型执行”**:由一个强大的 LLM 负责全局规划与决策,再用较小或专用的模型执行各子任务或工具调用。这样既减少了大模型调用次数、降低成本,又利用小模型在特定领域(如代码生成、算术计算)上的优势,实现更快更好的任务完成。

- 长期记忆管理与知识整合:Agent 在长时间、多话题的工作中,需要高效管理大量信息。这推动了更成熟的记忆模块发展,包括向量数据库、高效检索算法以及自动总结归纳技术。例如,一些 Agent 引入记忆池来存储过去的对话、已完成任务的结果摘要,必要时通过检索融合进新上下文。这种对知识碎片的整合使 Agent 能在长期运行中保持上下文连贯性和决策一致性,减轻了LLM上下文长度限制的问题。

- 标准化接口与插件生态:正如 MCP 所体现的,业界正走向为 Agent 构建标准化的接口层,使得模型、工具和数据源可以按统一协议对接。标准化接口与插件生态:正如 MCP 所体现的,业界正走向为 Agent 构建标准化的接口层,使得模型、工具和数据源可以按统一协议对接。开发者为某款 Agent 开发的工具插件,也能很容易地在另一款支持相同协议的 Agent 上运行,从而形成繁荣的插件生态。这一趋势与早期的 ChatGPT 插件、LangChain 工具链不谋而合:通过定义清晰的接口规范,第三方服务(无论是网络应用还是本地软件)都可以成为 Agent 的“手和脚”。可以预见,随着标准的融合与统一,未来我们与 AI Agent 交互时,将像使用浏览器插件那样方便,定制自己的Agent能力边界。

综上所述,大型语言模型驱动的自主 Agent 正在迅速演进,从架构范式(单智能体到多智能体、多模型)、协议标准(MCP 等开放协议)、到具体应用实践(软件开发、运维、数据分析等),都展现出令人兴奋的前沿进展。在 2025 年初,我们已经看到了多个富有潜力的系统雏形。可以预见,随着底层模型能力和生态的进一步成熟,LLM 自主 Agent 将在更多实际场景中落地,成为人类强有力的智能辅助,共同开创人机协作的新局面。

模型上下文协议规范在2025.03.26进行了修订重大变更

增加了基于 OAuth 2.1 的 全面授权框架(PR #133 )

使用更灵活的Streamable HTTP 传输取代了之前的 HTTP+SSE 传输(PR #206 )

增加了对 JSON-RPC批处理的支持 (PR #228 )

添加了全面的工具注释,以更好地描述工具行为,例如它是只读的还是破坏性的(PR #185)

参考资料:

- Lilian Weng. (2023). LLM-powered Autonomous Agents. Retrieved from:

https://lilianweng.github.io/posts/2023-06-23-agent/ - Yao, S., et al. (2023). ReAct: Synergizing Reasoning and Acting in Language Models. ICLR 2023. Retrieved from:

https://arxiv.org/abs/2210.03629 - Anthropic. (2024). Introducing the Model Context Protocol (MCP). Anthropic Blog. Retrieved from:

https://www.anthropic.com/blog/model-context-protocol - OpenAI. (2023). How to Call Functions with Chat Models. OpenAI Cookbook. Retrieved from:

https://github.com/openai/openai-cookbook/blob/main/examples/How_to_call_functions_with_chat_models.ipynb - Cognition Labs. (2023). Introducing Devin: The First AI Software Engineer. Retrieved from:

https://www.cognitionlabs.ai/blog/devin - OpenDevin Project (Open Source Version of Devin). (2024). Retrieved from:

https://github.com/OpenDevin/OpenDevin - GPT-Engineer Project. (2023). Retrieved from:

https://github.com/AntonOsika/gpt-engineer - Monica.im. (2024). Manus: Autonomous AI Agent IDE. Retrieved from:

https://monica.im/manus - Roo Code Official Website. (2024). Roo Code – AI Agent-based IDE Assistant. Retrieved from:

https://roo.dev - LangChain Official Documentation. (2024). Agent Types and Architectures. Retrieved from:

https://python.langchain.com/docs/modules/agents/ - Kuverto Blog. (2023). Exploring Popular AI Agent Frameworks: Auto-GPT, BabyAGI, LangChain Agents, and Beyond. Retrieved from:

https://kuverto.com/blog/ai-agent-frameworks - AI全书. (2025). 一文看懂什么是MCP(模型上下文协议). Retrieved from:

https://aibook.ren/ - OpenAI. (2024). ChatGPT Advanced Data Analysis (Code Interpreter) Feature. Retrieved from:

https://openai.com/blog/chatgpt-advanced-data-analysis - Towards AI. (2024). Building Intelligent Agents from Scratch: A Journey into LLM-Powered Autonomy. Retrieved from:

https://towardsai.net/p/l/building-intelligent-agents-from-scratch - GitHub Copilot Official Blog. (2023). Copilot X and Future of AI-assisted Development. Retrieved from:

https://github.blog/2023-03-22-github-copilot-x-the-ai-powered-developer-experience - CSDN博客. 《AGI之Agent:基于LLM驱动的智能体—三大组件…》2023: blog.csdn.net